« C’est cool d’utiliser l’ordinateur, mais ne laissez pas l’ordinateur vous utiliser » : aux États-Unis, les administrations et décideurs politiques ont décidé d’intensifier la pression mise sur les principaux dirigeants du secteur de l’intelligence artificielle, n’hésitant pas à se servir de cet avertissement de Prince dans leurs déclarations. Ces dernières 24 heures, deux annonces ont été faites. L’une par la Federal Trade Commission (FTC), l’autorité américaine en charge de la protection des consommateurs a émis des recommandations à destination des entreprises qui développent des IA génératives.

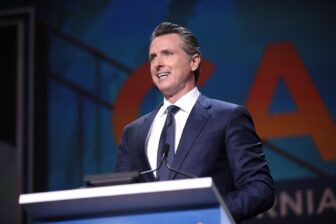

L’autre par la Maison Blanche, quelques heures plus tard : une rencontre aura lieu jeudi 4 mai, entre les grandes entreprises du secteur et l’administration Biden. Les dirigeants à la tête d’Alphabet, Microsoft, OpenAI, et Anthropic ont été invités à rencontrer la vice-présidente Kamala Harris et d’autres membres du gouvernement Biden. Sam Altman (OpenAI), Dario Amodei (Anthropic), Satya Nadella ( Microsoft) et Sundar Pichai (Google) ont bien confirmé qu’ils seraient au rendez-vous.

« Protéger les Américains des effets néfastes de l’IA »

Objet de la discussion, précisé dans une des invitations consultées par Bloomberg : « les risques que nous voyons tous dans le développement actuel et à court terme de l’IA, les actions visant à atténuer ces risques et d’autres moyens de travailler ensemble pour s’assurer que le peuple américain bénéficie des progrès de l’IA tout en étant protégé de ses effets néfastes ». L’invitation mentionne que le président des États-Unis « s’attend à ce que les entreprises (concernées) s’assurent que leurs produits sont sûrs avant de les mettre à la disposition du public ». Cette garantie de sûreté avait déjà été évoquée par Joe Biden en avril dernier. Washington souhaite mettre en place des garde-fous pour atténuer et éviter les risques d’une telle technologie.

Car « nous nous trouvons à un tournant décisif », a estimé la présidente de la Federal Trade Commission (FTC), Lina Khan, interviewée par le New York Times ce mercredi 3 mai, au lendemain de la publication d’un nouvel avis non contraignant de la FTC. La dirigeante a déclaré que « les responsables publics avaient la responsabilité de veiller à ce que l’histoire durement apprise (avec le web 2.0, ndlr) ne se répète pas ». Lors de l’apparition du Web, « ce qui avait commencé comme un ensemble de technologies révolutionnaires a fini par concentrer un énorme pouvoir privé sur des services clés et par verrouiller des modèles commerciaux qui ont un coût extraordinaire pour notre vie privée et notre sécurité ». Et il n’est pas question que l’histoire se répète à nouveau, a-t-elle prévenu.

Un message aux sociétés qui se séparent de salariés travaillant sur l’éthique

L’autorité de la concurrence, dans un avis non contraignant publié sur son site Web le mardi 2 mai, avait rappelé les risques soulevés par une IA utilisée à des fins frauduleuses, présentant des résultats biaisés ou discriminatoires pour les consommateurs. Elle demande aux entreprises de préciser ce qu’est, ou n’est pas, une publicité au sein de résultats générés par l’IA. Elle en a profité pour tacler les sociétés qui se séparent de leurs effectifs travaillant sur l’éthique et la responsabilité en matière d’IA comme Microsoft l’a fait en mars dernier.

« Ce n’est peut-être pas le bon moment pour les entreprises de licencier les employés » de ces départements, a-t-elle déclaré. « Si la FTC vous appelle et que vous voulez nous convaincre que vous avez correctement évalué les risques et atténué les dommages, ces réductions pourraient ne pas faire bonne figure », a-t-elle ajouté. L’autorité rappelle qu’il faut s’assurer « du suivi et de l’analyse de l’utilisation et de l’impact réels de tout outil finalement déployé ». Et si les IA se livrent à des pratiques déloyales ou trompeuses, l’autorité n’hésitera pas à sévir, a averti la présidente de la FTC, Lina Khan.

Une réglementation de l’IA « fondée sur les risques »

ChatGPT, adopté par près de 100 millions d’utilisateurs, suscite de nombreuses inquiétudes en terme d’impact sur l’emploi et sur l’humanité en général. Outre la lettre appelant à un moratoire de six mois qui sera restée sans effet, d’autres personnalités ont mis en garde contre cette technologie, à l’image de Goeffrey Hinton, un des pères fondateurs de l’IA. Celui qui est parfois désigné comme le « parrain de l’IA » a rappelé les « profonds risques pour la société et l’humanité » dans les colonnes du New York Times.

Ces initiatives ne sont pas sans rappeler d’autres déclarations ou législations visant à adopter la plus grande prudence ou à réglementer l’IA dans le monde depuis que le lancement de ChatGPT, en novembre dernier, a entraîné une course à l’IA. La semaine dernière, les ministres du numérique du G7 ont déclaré que les pays membres devraient adopter une réglementation de l’IA « fondée sur les risques ». Au sein de l’UE, le règlement sur l’IA, qui devrait faire l’objet d’un vote au Parlement européen le 11 mai prochain, compte bien soumettre les entreprises développant l’IA générative à de nombreuses obligations. En France, « la stratégie IA nationale » sera actualisée avant l’été, a promis Jean-Noël Barrot, le ministre chargé de la Transition numérique dans les colonnes de Libération de ce mercredi 3 mai.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : Bloomberg