Vedette de la Google I/O 2024, le Project Astra nous donne un aperçu d'un futur dans lequel nous pourrons converser sans fin avec un assistant intelligent capable de réagir en fonction de notre environnement.

Si vous suivez Google sur les réseaux, vous avez peut-être vu apparaître peu avant la conférence d’OpenAI une vidéo montrant un assistant vocal multimodal capable de répondre en temps réel à des questions intégrant un élément visuel de l’environnement. Cette démonstration a désormais un nom : Project Astra.

L’avenir est au multimodal

Poser une simple question à un moteur de recherche, un assistant vocal ou même à un ChatBot IA, c’est le passé. L’avenir se tourne à présent sur les requêtes multimodales liant une question, posée à l’écrit ou vocalement, et un autre élément, qu’il soit sonore ou visuel. Le but est de rendre la recherche beaucoup plus naturelle et les questions plus proches de ce que l’on pourrait demander à un humain. Imaginez demander « c’est quoi ça ? » à un assistant en pointant un objet avec votre smartphone.

Le multimodal est déjà une composante de Gemini, mais Google souhaite aller plus loin encore et réinventer ce que des films de science-fiction ont déjà imaginé, à l’instar de Jarvis dans Iron Man ou Samantha dans Her. Cette mission, c’est le Project Astra, développé par Google DeepMind. Il s’agit d’un assistant vocal capable de répondre en continu et en temps réel et non plus juste sur une requête précise.

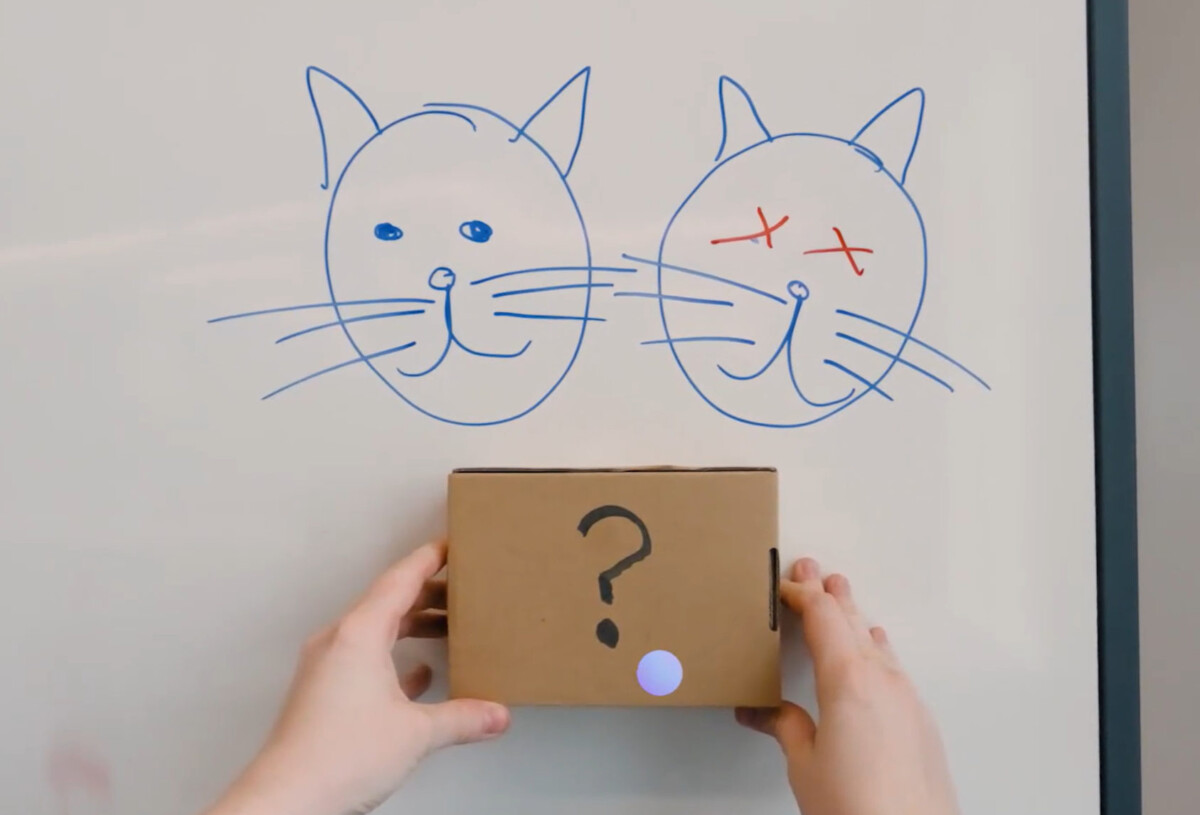

Que ce soit au travers de la caméra d’un smartphone ou d’un prototype de lunettes connectées, Project Astra est capable de répondre à des questions aussi diverses que « je suis dans quel quartier ? », « quel nom tu donnerais à ce duo ? », « que fait ce morceau de code ? » ou même « où est-ce que j’ai mis mes lunettes ? ». Un résultat impressionnant.

Google à la traine ?

L’exploit ne se trouve pas tant dans la compréhension du monde d’Astra, mais dans sa réactivité. « Ramener le temps de réponse à un niveau conversationnel est un défi technique difficile à relever », précise Google dans son communiqué de presse. C’est très certainement pour cela qu’il ne s’agit encore que d’un projet, même si l’application Gemini héritera de certaines de ses capacités dans l’année.

Cette démo impressionnante est cependant gâchée par l’annonce hier des améliorations de ChatGPT Voice. L’assistant conversationnel d’OpenAI reste à faire ses preuves sur de nombreux points, à commencer par la précision de ses réponses, mais il garde une longueur d’avance sur un point : le rendu de la voix. Alors que Google a opté pour une voix encore un peu robotique, semblable, voire identique à celle de Google Assistant, ChatGPT Voice utilise des intonations et des marqueurs vocaux plus humains, plus naturels et moins monotones. Si d’aucuns y ressentiront un effet de « vallée dérangeante », il ne fait aucun doute que c’est là un argument important pour l’adoption à grande échelle.

De plus, la version alpha de cet outil sera disponible pour les abonnés ChatGPT Plus dans les prochains semaines. L’année s’annonce ultra concurrentielle dans le domaine…

Retrouvez un résumé du meilleur de l’actu tech tous les matins sur WhatsApp, c’est notre nouveau canal de discussion Frandroid que vous pouvez rejoindre dès maintenant !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et ses partenaires.

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.

Gérer mes choix