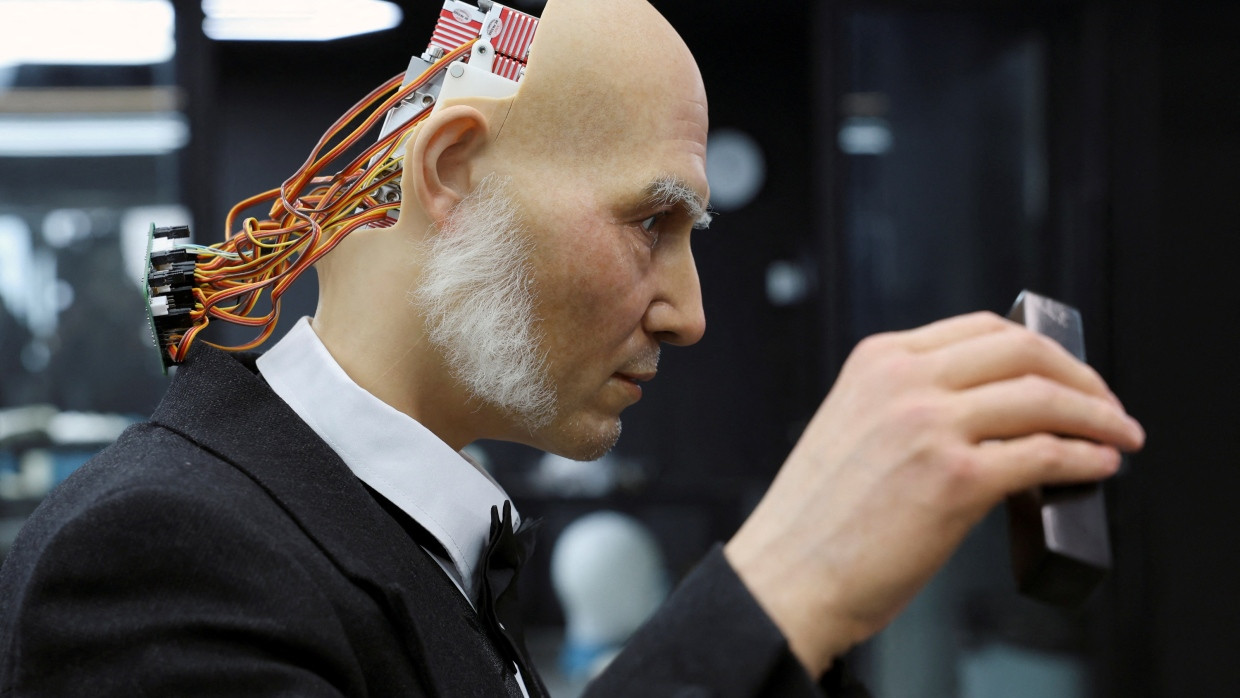

Zukunft der KI : Das Phantom „Superintelligenz“ – zwischen Hype, Angst und Wirklichkeit

Seit den frühen Anfängen der Künstlichen Intelligenz (KI) gibt es Befürchtungen über das Entstehen einer „Superintelligenz“. Diese Ängste sind tief verwurzelt und reichen zurück bis zu den ersten Visionen von Maschinen, die eigenständig denken und handeln können – Szenarien, die wir aus Science-Fiction-Filmen wie Alien, Blade Runner oder Terminator kennen. Ein wesentlicher Faktor, der diese Ängste schürt, ist der Begriff KI selbst. Würden wir hingegen von Maschinellem Lernen sprechen – der grundlegenden Technologie hinter Künstlicher Intelligenz – wären die Sorgen der Menschen vermutlich deutlich geringer. Das ist die eine Seite.

Superintelligenz – Apokalypse now?

Auf der anderen Seite warnen auch viele sehr bekannte Unternehmer und Wissenschaftler vor einer Superintelligenz. Zu den prominenten Persönlichkeiten gehört unter anderem Elon Musk, der regelmäßig vor den Gefahren der Künstlichen Intelligenz warnt. Auch der weltweit führende KI-Anbieter Open AI, insbesondere CEO Sam Altman sowie der Mitgründer Ilya Sutskever, der das Unternehmen verließ, um sichere KI zu entwickeln, sorgen sich öffentlich vor den möglichen Risiken einer Superintelligenz. Im Englischen spricht man in diesem Zusammenhang auch häufig von AGI (Artificial General Intelligence). Einer Meldung der „New York Times“ zufolge könnte eine Klausel im Vertrag zwischen Open AI und Microsoft den Zugang von Microsoft zu Open AIs Technologie beenden, wenn das KI-Unternehmen AGI erreicht.

Auch der Physiker und Nobelpreisträger Geoffrey Hinton warnt eindringlich vor den weitreichenden Gefahren einer AGI. Er weist auf die potentielle Nutzung durch Populisten hin, die AGI zur Manipulation der Öffentlichkeit einsetzen könnten, ebenso wie auf die Gefahr, dass sie als Kriegswaffe missbraucht wird. Darüber hinaus fürchtet er, dass eine unkontrollierbare Superintelligenz zur existenziellen Bedrohung für die Menschheit werden könnte.

Diese Art von Warnungen vor KI durch Wissenschaftler ist übrigens nicht ganz neu: So trauten Herbert A. Simon, der später den Nobelpreis gewann, oder der MIT-Forscher Marvin Minsky der KI bereits in den Sechziger- und Siebzigerjahren zu, es bald mit der Intelligenz von Menschen aufnehmen zu können. Minsky sagte beispielsweise 1970 dem „Life Magazine“: „In from three to eight years we will have a machine with the general intelligence of an average human being.“

Warnungen stoßen auf Resonanz

Behauptungen über das Entstehen einer Superintelligenz finden in vielen Medien und der breiten Öffentlichkeit oft fruchtbaren Boden. Selbst die Warnung des weitgehend unbekannten Google-Softwareentwicklers Blake Lemoine, der vor einer KI mit Bewusstsein und der Gefahr einer „fliehenden KI“ sprach, löste weltweit Schlagzeilen aus. Auch Menschen, die beruflich wie privat wenig bis gar nichts mit Künstlicher Intelligenz zu tun haben, argumentieren häufig mit der potentiell zerstörerischen Kraft der KI – interessanterweise wird eine Gegenargumentation in den meisten Fällen nicht angenommen. Vielleicht schwingt auch ein gewisser Nervenkitzel mit, wenn es um solche düsteren Zukunftsvisionen geht.

Aber bleiben wir bei der Frage, warum kluge Menschen und KI-Kenner wie Sam Altman oder Geoffrey Hinton vor einer AGI warnen? Haben sie tatsächlich ernsthafte Bedenken? Geht es ihnen möglicherweise um öffentliche Aufmerksamkeit oder strategisches Marketing? Oder versuchen sie, sich als verantwortungsbewusste Persönlichkeiten in der Gesellschaft zu positionieren?

Interessant ist die Wortwahl der amerikanischen KI-Superstars: KI wird mit Nuklearwaffen oder Nordkorea verglichen. Sutskever warnte in einem Blog vor dem Aussterben der Menschheit. Mitunter entsteht der Eindruck eines regelrechten Wettstreits um die dramatischsten Vergleiche. Gleichzeitig ist die Argumentation häufig nicht schlüssig: Elon Musk etwa warnt vor den Risiken von KI, setzt sie jedoch selbst für autonomes Fahren ein und lässt mit „Grok“ ein eigenes Sprachmodell entwickeln.

Ilya Sutskever warnt in einem Blogbeitrag vor AGI, die die Menschheit gefährden könnte, und sucht im gleichen Beitrag nach KI-Experten. Erschwerend kommt hinzu, dass der Begriff AGI gar nicht klar definiert ist und somit eine Art Phantomdiskussion geführt wird. Die renommierte Stanford-Professorin Fei-Fei Li, als „Godmother of AI“ bekannt, kommentiert diese Debatte mit nüchterner Gelassenheit: „I frankly do not know what AGI is … and I don’t spend much time thinking about these words because I think there are so much more important things to do.“

Die Umkehr der Beweispflicht

Bemerkenswert ist, dass warnende Stimmen vor einer AGI oft nur vage oder gar keine fundierten Begründungen für ihre Bedenken anführen. Häufig wird argumentiert, dass KI außer Kontrolle geraten könnte oder dem Menschen bereits überlegen sei. Diese Aussagen treffen jedoch nur teilweise zu: Zwar kann KI den Menschen in bestimmten, klar definierten Aufgabenbereichen übertreffen – etwas, das aber auch für traditionelle Algorithmen, Automatisierungssysteme oder sogar für einfache Taschenrechner zutrifft.

Doch die Stärke der KI liegt nach wie vor in spezialisierten Anwendungen. Fähigkeiten wie ganzheitliches, anwendungsübergreifendes Denken oder gar Eigenschaften wie Empathie und Bewusstsein sind bisher (noch?) nirgends erkennbar. Das menschliche Gehirn bleibt Künstlichen Neuronalen Netzen überlegen – nicht zuletzt, wenn man den Energieverbrauch betrachtet.

Apokalyptisch klingenden Warnungen sollte mit einer gesunden Portion Skepsis begegnet werden. Denn die prominenten Mahner ignorieren ein grundlegendes Prinzip der Logik, Philosophie und Rechtswissenschaft: Die Beweislast liegt grundsätzlich bei denjenigen, die eine Behauptung aufstellen. Wer etwa behauptet, dass im Jahr 2025 ein UFO auf dem Dach des F.A.Z.-Towers in Frankfurt am Main landen wird, muss diese Aussage mit Fakten und Beweisen untermauern – es ist nicht die Aufgabe der Zweifler, das Gegenteil zu beweisen. Würde man dieses Prinzip aufgeben, müssten alle unbewiesenen Behauptungen als gültig akzeptiert werden. Der Philosoph Karl Popper unterstrich in seinem Konzept der Falsifizierbarkeit ebenfalls, dass es an den Wissenschaftlern liegt, ihre Hypothesen mit Belegen zu stützen. Skeptiker hingegen sind nicht verpflichtet, jede unbewiesene Aussage zu widerlegen.

Die rasanten und beeindruckenden Fortschritte im Bereich der Künstlichen Intelligenz, insbesondere bei der Generativen KI (GenAI), sollten jedoch nicht unterschätzt werden. Im Gegenteil: Diese Entwicklungen erfordern eine sorgfältige und kritische Auseinandersetzung. Wie Fei-Fei Li es vorschlägt, sollten wir unseren Blick auf die Innovationspotentiale richten und gleichzeitig die wirklich großen gesellschaftlichen Herausforderungen im Auge behalten – ein Beispiel hierfür ist das Thema der Fake News. GenAI hat inzwischen ein so hohes Niveau erreicht, dass es für Menschen (und auch für die KI selbst) zunehmend schwierig wird, zwischen Realität und KI-generierter Fiktion zu unterscheiden.

Plädoyer für mehr interdisziplinäre Bildung

Technologisch gesehen ist es mittlerweile nahezu unmöglich, Fake News zuverlässig zu identifizieren. Was können wir also tun? Der vielversprechendste Ansatz ist Bildung – und zwar nicht nur im Bereich der KI, sondern interdisziplinär, ergänzt um Empathie und gesunden Menschenverstand. Nur eine solche umfassende Bildung kann den Menschen dabei helfen, die Plausibilität von Texten oder Bildern besser einzuordnen und Fiktion von Realität zu unterscheiden.

Dies gilt nicht nur für die Erkennung von Fake News, sei es im Kontext politischer Manipulationen, der Verbreitung von Verschwörungstheorien oder anderer Formen der Desinformation. Diese Kompetenz ist ebenfalls nützlich, wenn es darum geht, apokalyptische Warnungen vor einer möglichen AGI kritisch zu hinterfragen.